AI年代:给AI装耳朵 识听识唱识奏乐 中大教授研音频AI 冀像人类理解声音(组图)

发布 : 2025-6-30 来源 : 明报新闻网 用微信扫描二维码,分享至好友和朋友圈 | 加关注  明声网温哥华 微信公众号 |

中大电子工程系其中一个数字信号处理实验室,并不是想像中放满专业声学设备,跟录音棚一样的房间。中大电子工程系助理教授孔秋强(左)表示,他的工作重点是AI,也就是一个「码农」,专业设备就是几部电脑。(陈灏??o?J??

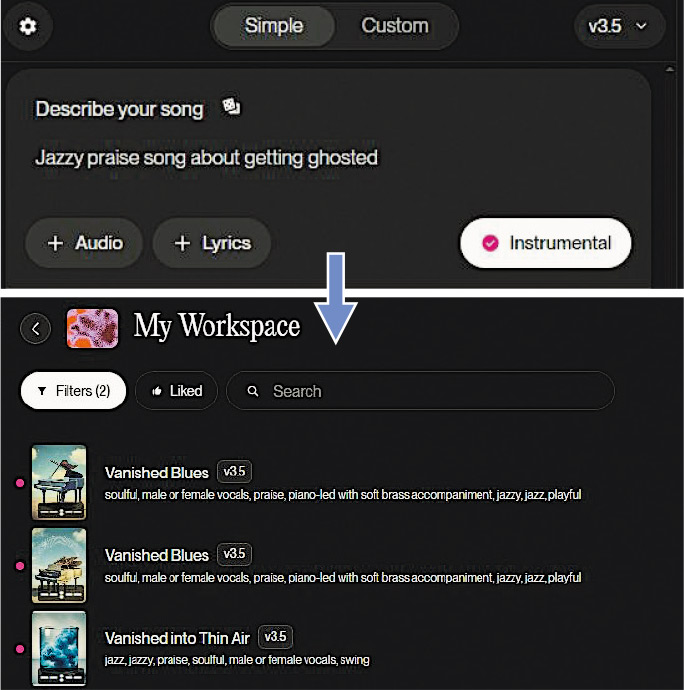

作曲AI「SUNO」可根据用户描述(上图)生成长度约3分钟音乐(下图)。有音乐制作人表示,SUNO效果惊艳,其生成歌曲的和声质量,不少初级音乐制作人都做不到这种程度。(网上图片)

作为中大数字信号处理实验室(DSP Lab)的一员,孔秋强目前从事音频AI相关研究,其中一个范畴是音频理解,孔秋强形容是「给一个大语言模型装上耳朵」,目标是让AI能像人类一样理解声音,包括对音频标签、分类,例如串流平台向用户??u荐感兴趣的音乐;音频事件监测,例如判断公共场所发生事故、长者在家出现意外等;音源分离,例如将一首歌的人声和伴奏分开。

语音合成技术最普及 人声成熟

在音频生成领域,孔秋强表示,针对业界的应用场景可以分成语音、音乐、音效3种不同任务;其中,AI生成音效过去探索相对较少,但重要性很高,特别是对多媒体内容创作。目前市面上应用最广泛的是语音合成(Text to Speech)技术。该技术由来已久,但近年在AI的加持下效果大幅提升,声调抑扬顿挫、拆句自然流畅。孔秋强表示,电脑合成出来的「人声」音色愈来愈丰富、情感愈来愈多样、语速愈来愈快。他说,在短片平台流行的当下,许多影片中的旁白其实并非真人配音,而是由AI合成,目前公众知道的几乎所有大型互联网企业都投入了大量资源从事相关开发。

英国AI企业DeepMind在2016年??u出了第一个能够生成音乐波形的模型WaveNet,之后陆续出现了OpenAI的Jukebox、Google的MusicLM等项目。孔秋强表示,音乐AI目前?x??初级阶段,虽然实现了从文本指令生成音频,但AI生成出来的音乐并不具有美学上的意义。孔秋强表示,将SUNO等音乐AI称作「音乐界的ChatGPT」,是因为不同媒介的生成式AI背后的技术方案均基于变换器(Transformer)模型。用户所见,ChatGPT、DeepSeek等应用的回答是逐字逐字生成的,音乐AI的歌曲则是逐帧逐帧生成的,都显示出变换器模型的特点。

音乐AI尚欠美感 训练数据制约发展

2020年发表的扩散模型(Diffusion Model)成为AI领域里程碑,对音乐AI也有极大??u动。孔秋强表示,音频可以转换成频谱图(Spectrogram),音乐生成转换为图像生成,而扩散模型在图像生成方面有出色表现。2022年发表的SUNO应用了扩散模型,可以生成音质更好的音频;转换模型在长上下文相关性的优势,让生成出来的音乐结构较为完整。孔秋强认为,扩散模型问世至今,在下一个根本性突破出现之前,训练数据是目前制约AI发展的瓶颈。对于构建音频生成AI,关键是平行数据。平行数据指音频及其描述,包括长度、速度、节拍、风格、乐器、歌手、歌词等,描述愈详细平行数据质量愈高,但这些内容依赖人类贡献。

AI令音频变琴谱 未来或「反哺」作训练

孔秋强加入中大前曾供职于北京的字节跳动人工智能实验室,其主导的钢琴转谱(Transcription)项目「GiantMIDI-Piano」用AI将逾万段钢琴独奏音频,转为并非声音本身而是一系列演奏指令的MIDI文件;AI除了音高、节奏、强弱等基础信息,还能够分析出琴键、踏板的状态,更忠实还原音乐家的临场演奏效果。除了偶尔在高级饭店出现的自勾x??奏钢琴,孔秋强表示,钢琴转谱技术目前最大的用途是音乐教育,一些手机应用程式能检测初学者的演奏是否正确,用AI教人弹琴。另外,AI提高转谱的效率,未来可能将世界上现存的所有歌曲变为MIDI文件,「反哺」给AI作为训练数据,提升AI的性能。

明报记者